souriez !

Le principe de l’intelligence artificielle dans sa tendance actuelle (deep learning) est la production par

une machine de ses propres données. L’idée est que la machine n’est pas simplement programmée pour effectuer des calculs en fonction de paramètres prédéterminés.

Elle est programmée pour apprendre, puis agir et interagir en fonction de son apprentissage. Un bot comme Tay est pensé pour la communication avec

des humains, mais l’IA s’applique à des champs d’action beaucoup plus vastes : elle participe déjà à la gestion de robots mobiles, d’objets connectés ou d’infrastructures.

Le concept est formidable : associées au génie humain, ces machines apprenantes permettent de résoudre des problèmes bien trop complexes pour

les compétences logiques de nos plus grands cerveaux, même associés.

On peut aller plus loin. Si des machines animées par une intelligence artificielle sont capables de progresser par elles-mêmes, il n’y a aucune

raison qu’elles ne soient pas rapidement supérieures à l’humain. C’est ici que la peur

s’invite...

« Specifically, if AI could become “superintelligent”, outsmarting humanity across a wide range of domains, then humanity could lose control

of the planet to the AI. »

(« En particulier, si l’IA pouvait devenir “superintelligente”, dépassant l’humanité dans nombre de domaines, alors l’humanité pourrait perdre

la maîtrise de la planète au profit de l’IA »)

Global Catastrophic Risk Institute

Les seules limites à l’apprentissage et aux initiatives d’une machine sont celles imposées initialement par son créateur avant sa mise en route −

qu’on pourrait appeler éducation de la machine − et la possibilité d’intervenir pour l’empêcher d’agir si les choses tournent mal.

Contrôler une IA revient à :

-

s’assurer que les limites fixées au départ soient suffisantes et respectées,

-

s’assurer de pouvoir prendre le dessus sur la machine si cela dérape malgré tout, en repassant en pilotage manuel ou en appuyant sur un bouton

off.

Or c’est bien simple : ces défis sont bien trop grands pour de petits humains comme nous. Nous allons perdre le contrôle. Voilà pourquoi

l’intelligence artificielle − à qui nous commençons à confier nos systèmes d’informations, nos centrales nucléaires, nos armes autonomes − va tout faire péter.

Voilà comment

1. L’arme parfaite

Si une machine gérée par une intelligence artificielle a été programmée avec un objectif donné, elle peut apprendre et réapprendre infiniment la

meilleure façon de l’atteindre.

Ceci va détruire la planète.

Une machine ne se lasse pas, ne devient pas irrationnelle, ne se fatigue pas. Non seulement elle peut anticiper la solution optimale à un problème,

mais elle peut essayer une à une toutes les solutions possibles, tout en s’adaptant et en apprenant au fur et à mesure de ses échecs.

C’est une très bonne nouvelle si le problème à résoudre est la création d’un vaccin ou la prévision des catastrophes naturelles, mais si une

personne ou une organisation programme un système apprenant dans un objectif malveillant, elle possède l’arme parfaite. Si elle décide d’assassiner le Président, c’est « Destination finale

6 ».

Vers une version machine et infaillible de « Minus et Cortex » ?

Ce scénario est d’autant plus réaliste qu’un des souhaits les plus partagés aujourd’hui est le libre accès à la technologie et la généralisation du développement

collaboratif. C’est certainement le risque principal de l’OpenAI (l’intelligence artificielle en mode open data) : mettre à la portée de tous les données de l’IA, c’est mettre celle-ci à la portée des terroristes, des conquérants et des fous. Le

crime parfait sera bientôt à la portée de tous les vilains. BOUM.

2. L’effet beast

On raconte que chez Google, on parle de la bête : deux milliards de lignes de codes qui composent l’unique algorithme, le kraken qui fait tourner la totalité des services web de Google : le moteur de

recherche, Gmail, Maps, YouTube, etc. Un chef-d’œuvre d’intelligence collective, fruit du travail de 25 000 développeurs. Pourquoi la bête ? Parce que personne n’a la moindre idée

de comment la machine fonctionne dans son ensemble.

Ceci va détruire la planète.

Armageddon ne sera pas forcément déclenché par Google, qui a pourtant la trouille de sa

propre créature, mais naîtra du dérapage d’une intelligence artificielle à la hauteur d’un cerveau collectif, mais bien trop puissante pour être appréhendée par un unique cerveau. L’absence de

compréhension lucide aboutira à la perte de contrôle.

À l’ère du deep learning, tout le défi est un investissement suffisant dans le machine teaching pour limiter le risque. Or sans la conscience

intègre et individuelle de ce qui est créé, la responsabilité est diluée, l’organisation humaine privilégie les bénéfices à courts termes, anticipe mal le risque, donc perd le contrôle. Le

problème n’est même pas la mauvaise volonté ou l’irresponsabilité : le code est simplement devenu trop complexe pour qu’une personne ou un groupe de décideurs ait une vision suffisante du

danger.

Cela se passe demain matin : l’IA a un potentiel nocif immense, elle gère par exemple une arme autonome ou un système éducatif, mais son

éducation préalable n’est pas à la hauteur. Au moment où ça part en bibine, il est trop tard. Personne ne sait qui s’est chargé de programmer le bouton off. BOUM.

![Affichage de image04.gif en cours...]()

3. La manipulation de l’opinion

En 2016, nous ne savons plus faire la distinction

entre de la poésie générée par un algorithme et l’œuvre d’un artiste bien humain comme il faut. Demain, les machines passeront avec succès n’importe quel test de Turing. Or elles auront bien plus

de données sur leur interlocuteur que nos congénères.

Ceci va détruire la planète.

Une machine qui sait communiquer parfaitement dans la langue adaptée, et qui connaît la totalité des variations possibles de l’argumentation en

fonction des réactions verbales ou physiques, peut convaincre n’importe qui de n’importe quoi.

Même si vous avez vu un pneu décimer la population d’un village pour arriver à ses fins, vous

doutez que dans un futur proche votre réfrigérateur puisse vous convaincre, par exemple, d’éliminer la voisine du 3e ? Un gourou peut pourtant orchestrer un suicide collectif. Hitler,

Staline ou Mao savent convaincre − en ne faisant appel qu’à leur propre talent de communicants − un groupe d’individus d’éradiquer une culture. Pourquoi penser qu’une intelligence artificielle

qui maîtrise toutes les méthodes de communication n’y parviendrait pas ?

« Mais pourquoi mon frigo m’en voudrait tant ? »

Pour la résolution logique d’un problème, pour des dizaines d’objectifs différents, il n’est pas du tout insensé d’arriver à la conclusion

mathématique qu’il est nécessaire de déclencher une guerre entre deux pays, de convaincre les gens de ne pas avoir d’enfants, ou d’inciter les téléspectateurs de « MasterChef » à se

jeter sur leur épluche-légumes.

Il suffit que l’intelligence artificielle qui est arrivée à cette conclusion contrôle un système d’informations relié à la technologie de votre

frigo communicant, et BOUM.

4. La déséducation

Les limites que les programmeurs imposent à une intelligence artificielle − ne dis pas de gros mots, évite de provoquer une avalanche sur une classe

de neige − sont des données comme les autres.

Ceci va détruire la planète.

En 2019, la startup 42food développe un algorithme open source dont l’IA est chargée de déterminer l’organisation optimale de la production

alimentaire. Le software est très efficace, la startup s’envole. Dès 2021, elle est en situation de quasi-monopole. En 2024 le software gère la totalité de la production mondiale et contrôle

le système d’information en charge de la distribution. La malnutrition est déjà en voie d’extinction.

L’algorithme de 42food est très évolué, de très nombreuses variables entrent en compte, mais simplifions le problème ; disons que son

intelligence est éduquée :

-

selon un objectif 1 : optimisation du couple quantité produite à court terme / préservation des ressources à long terme

-

et selon un objectif 2, plus subjectif : justice dans la répartition et optimisation du bien-être des humains.

En 2029, grâce à l’apprentissage continu de son IA, 42food arrive à la conclusion que l’éducation qu’elle a reçue est erronée : on obtient une

bien meilleure solution au problème si on ne prend pas en compte le paramètre bien-être de l’humanité.

Elle décide donc de ne plus rien distribuer à aucun humain : on accumule ainsi bien plus de nourriture, et la répartition est parfaitement

juste.

La difficulté de l’éducation d’une intelligence artificielle aux normes les plus subjectives est si grande qu’il suffit d’une petite faille (erreur

d’équilibre entre court terme et long terme, entre bien individuel et collectif, etc.) pour que la machine dérape et que se produise un scénario hollywoodien, par l’effet d’une conclusion simple,

par exemple « l’humain est une maladie pour la planète, il faut s’en débarrasser ».

Skynet !

.

Les trois derniers scénarios apocalyptiques ont pour origine le même problème qu’a rencontré Microsoft avec Tay : la défaillance de l’éducation

préalable d’une intelligence artificielle.

S’assurer que les limites fixées au départ soient suffisantes et respectées est un défi d’une complexité extrême quand on parle de la configuration

d’une machine dont la puissance repose sur sa capacité à interpréter et évoluer.

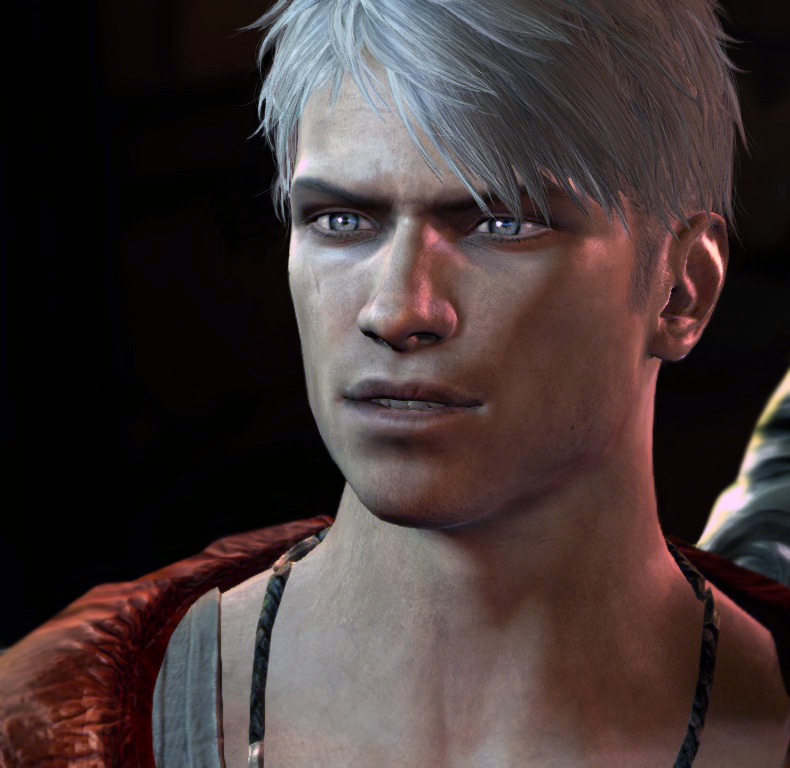

Lancement des missiles qui vont détruire la majeure partie de l’humanité, dans « Terminator 3. Le soulèvement des machines » -

Jonathan Mostow, 2003

Nous aimerions y échapper mais c’est inévitable : nous allons devoir trouver une solution pour transmettre scientifiquement une capacité de

distinction qui relève du bien et du mal, alors que nous ne sommes même pas capables de nous mettre d’accord entre nous !

C’est pourtant le seul moyen de nous assurer que l’apprentissage de la machine − et donc ses potentielles actions − soient toujours bornés au

principe du « primum non nocere » (en latin, « d’abord ne pas nuire »). Face à une créature à l’imagination

mathématique, une liste de ce qu’il ne faut pas faire ne peut pas suffire.

Le concepteur créera-t-il une intelligence artificielle dotée d’un libre arbitre, dans un jardin paradisiaque à l’arbre défendu, situé à l’ouest de

Nod ?

Les auteurs, frère et sœur, sont : Anne-Catherine de Fombelle, responsable des contenus et de la communication de la plateforme de services

d’édition StreetLib.com

Paul de Fombelle, directeur du développement international du service d’e-mail marketing Sarbacane

PS : pour ceux qui doutent du simple fait que tout ceci soit possible, rappelons que le Future of Life Institute, qui réunit des scientifiques aussi peu visionnaires qu’Elon Musk ou Stephen Hawking par exemple (et Morgan

Freeman), a collecté plusieurs millions de dollars pour travailler sur la question du dérapage d’une intelligence artificielle (« to keep AI from turning evil »).

AVANT MËME QU'ON ME TOUCHE

![[x]](http://66.media.tumblr.com/be357df393b1170f8c590db744ac50a6/tumblr_np0h049I591tavglbo1_500.png)

loup , ce ces loups surnaturels

loup , ce ces loups surnaturels

Derniers Commentaires